JC03 - งานวิจัยจาก Microsoft เผย “ยิ่งถามเยอะ AI ยิ่งตอบผิด” !

Published:

ChatGPT และรวมถึงแชท AI ต่างๆ อย่าง Gemini หรือ Claude เป็นตัวอย่างของ Large language model (LLM; แบบจำลองภาษา) ด้วยความฉลาดของมันในการตอบคำถาม ทำให้การใช้ LLM เป็นที่แพร่หลาย ตอนนี้คนหลายคนเริ่มถาม LLM มากกว่า ถาม Google search แล้ว แต่รู้ไหมว่าการถามหลายรอบแบบนี้ อาจทำให้ AI ตอบผิดมากขึ้น?

เคยไหมครับ ที่คุยกับ ChatGPT แบบนี้:

- “สรุปบทความนี้ให้หน่อย”

แน่นอน! นี่คือบทความสรุป..- “ขอสั้นกว่านี้ได้ไหม”

ได้เลย! นี่คือบทความสรุปที่ปรับปรุงแก้ไขให้สั้นลง..- “พูดเกี่ยวกับบทนำมากกว่านี้หน่อย”

รับทราบ! นี่คือบทความสรุปที่เน้นเนื้อหาของบทนำ..

งานวิจัยจาก Microsoft เผยว่าการสนทนาแบบหลายรอบ (multi-turn) แบบนี้ทำให้คำตอบของ AI นั้นมีความถูกต้องลดลงอย่างเห็นได้ชัด

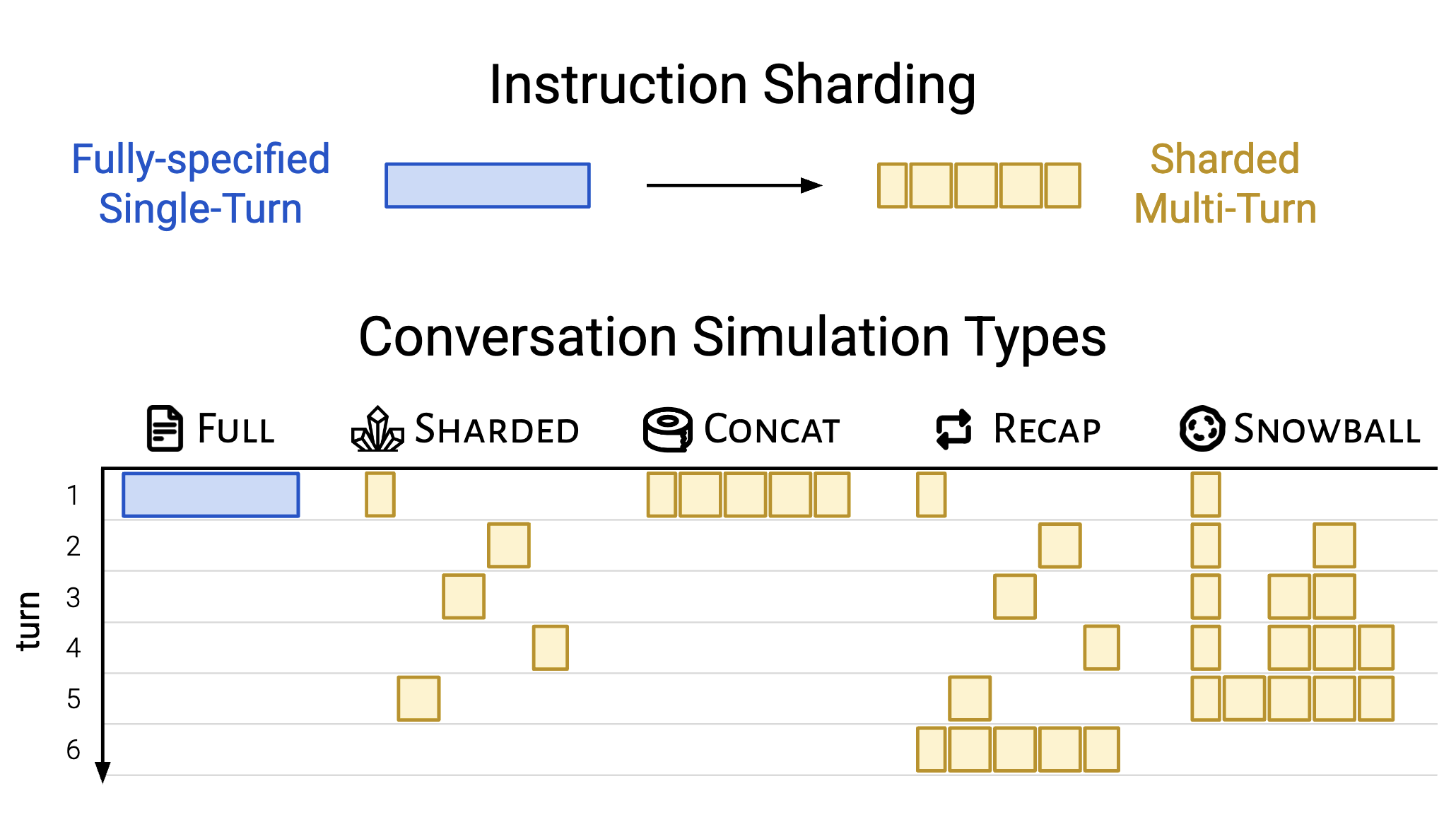

นักวิจัยได้นำชุดข้อมูล (dataset) GSM8K ที่มี คำสั่งต้นฉบับที่มีข้อมูลครบถ้วนในรอบเดียว (fully-specified instruction) มาทำการแบ่งเป็นชุดคำสั่งย่อยที่เล็กลง (sharded instructions; shards) shard ก็คือการแบ่งคำสั่งใหญ่ๆ ออกเป็นส่วนเล็กๆ เช่น แทนที่จะถามว่า ช่วยอธิบายบทความนี้ทั้งหมด ก็อาจจะแบ่งเป็น ช่วยอธิบายแค่บทนำ แล้วค่อยถามส่วนต่อๆ ไป

จากนั้นนำมาทำการจำลองการสนทนาแบบต่างๆ:

- Single-turn:

- FULL: ใช้คำสั่งต้นฉบับที่มีข้อมูลครบถ้วนในรอบเดียว

- CONCAT: นำ shards ท้ังหมดมารวมกันและนำเสนอในรอบเดียว

- Multi-turn:

- SHARDED: เปิดเผย shards ทีละ shard ในแต่ละรอบการสนทนา

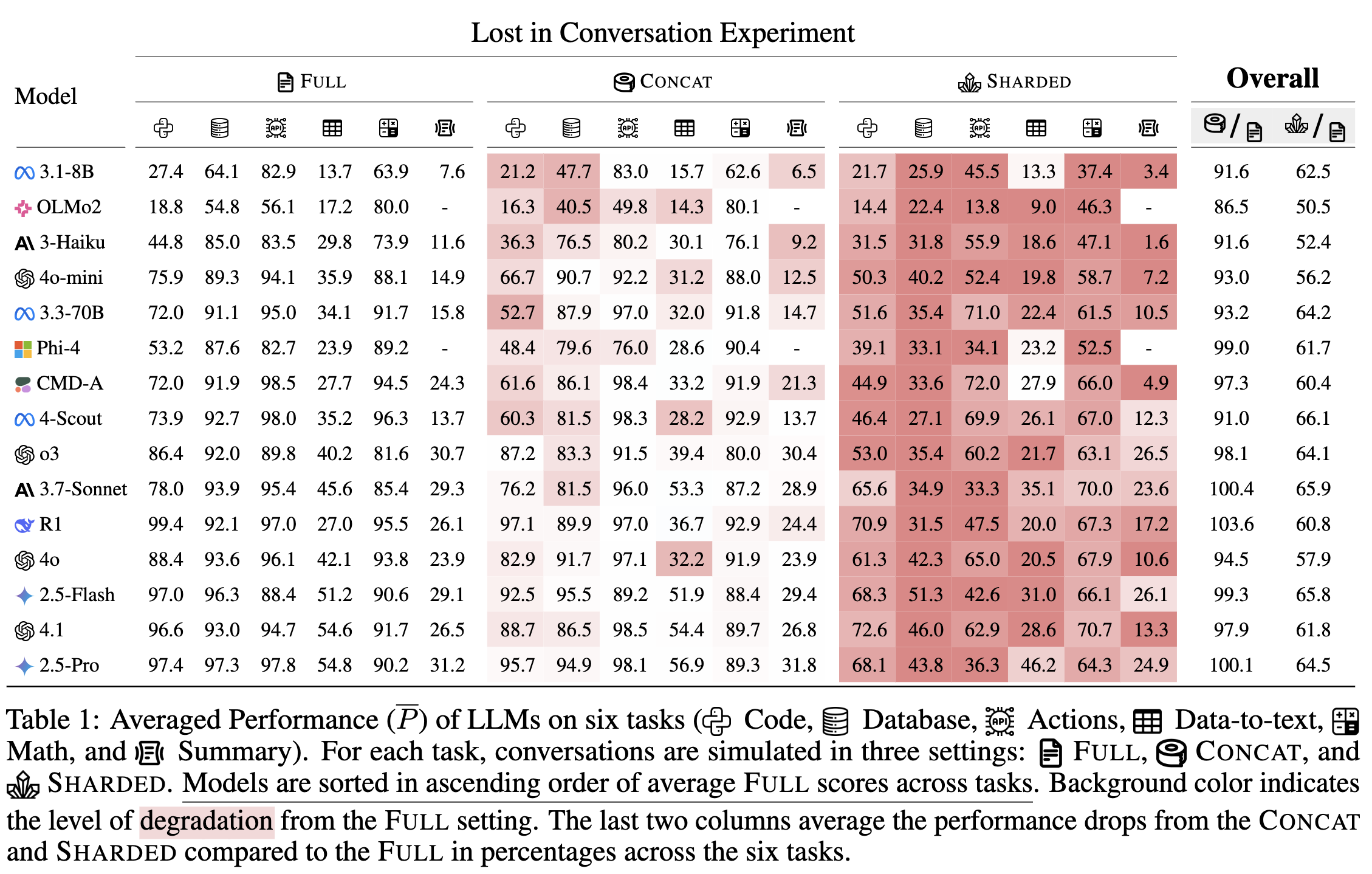

Task ที่ใช้ทดสอบมีหลายประเภท: Code, Database, Actions, Data-to-Text, Math และ Summary และจะประเมินผลผ่านสมการ Average Performance, Aptitude (ความสามารถของ AI ในการให้คำตอบที่ถูกต้อง) และ Unreliability (โอกาสที่ AI จะตอบมั่วแม้จะมั่นใจ)

ผลลัพธ์ที่ได้เป็นดังตารางนี้:

จากตารางจะเห็นว่า…

- FULL (ถามให้ครบในรอบเดียว) ได้คะแนนดีที่สุด

- SHARDED (ถามทีละนิด) มีคะแนนแย่ที่สุดในหลาย task

แปลว่าการถามให้ครบในรอบเดียวจะช่วยให้ได้คำตอบแม่นยำกว่า ดังนั้น ถ้าอยากได้คำตอบดีๆ จาก ChatGPT หรือ AI ตัวอื่นๆ พยายามถามให้ครบ ให้ชัดในรอบเดียว จะดีกว่าค่อยๆ ถามทีละนิดนะครับ !